メルカリに学ぶ深層学習基盤

tensorflow(keras)やchainerのおかげで深層学習モデルを実装できる人は増えてきたわけですが、そのモデルをシステムとして安定運用する基盤(機械学習基盤)は、作り方や運用の仕方を含めてまだ世の中的にもベストプラクティスを模索中のようです。

ちなみにこういった話は、機械学習 (MachineLearning) と運用 (Operations) ということで、DevOpsに倣って"MLOps"と呼ぶのが今風だそうです。

各事業会社がアプリやウェブコンテンツを作成すると、その機能には当然のようにユーザーセグメントやレコメンド、画像識別機能など、機械学習を常用する機能が必要となる昨今では、「今 システム基盤作るなら、将来的に深層学習も見据えて機械学習基盤を作りましょう」となるようで、事業会社ではホットなトピックのようです。

そんなホットなトピックを、ホットなメルカリさんがお話されるということで聞いてきました。 メルカリで実運用されている機械学習(深層学習)基盤のお話です。

スピーカーはメルカリのAI部2名で各30分。話題はそれぞれ

- メルカリにおける深層学習を用いた商品画像識別(出品アイテムの約1000クラスの分類タスク)

- AI部が構築している機械学習基盤(MLOps)について

※ 以下、突然の雑メモ。ビール片手に聞いていたのでちょこちょこ間違っているところがあると思われる

メルカリの商品画像識別

- 山口 拓真さん

- OCR/computer vision, super resolutionとかをずっとされていた方

- 前職はゲーム会社の分析基盤エンジニア

- 現在はメルカリサービスにおける画像認識タスク全般

- やってること: メルカリに出店された商品に自動でカテゴリーやブランド名を付与する機能の構築

- メルカリには1100商品カテゴリーがある

- inception v3を使って220Mの出品商品画像をスクラッチで学習

- 最初にやったときは29%エラー程度の精度

- 識別が難しかったやつ

- メンズとレディースのコンバースを分類(サイズが違うだけなのでムリ)

- 膝丈ドレスと膝上ドレスの分類(着る人によって違うやん...ムリ)

- アウトドアシューズか普段履きシューズか(人間でもわからんやん...むずい)

- 意外に出来たやつ

- 子供用スニーカー/大人用スニーカーの分類

- ニューバランスの大人用スニーカーはkid用とならずにきちんと分類できる

- 子供用スニーカー/大人用スニーカーの分類

- カテゴリ認識だけでなくブランド認識もできてる

- グッチ、トミーヒルフィガーなど分類できてる

- 画像中の非常に小さなブランドロゴでも意外にきちんと見つけて識別している

- ちなみに商品の正解ラベルはユーザーが出品時にラベル付けしたものを利用

- 投稿画像は全て正方形になるので学習するときいろいろ楽

- 深層学習アルゴリズムがどこに注目して識別しているかを可視化

- ブランド物の場合、ちゃんとロゴに注目している。しかも小さなロゴまで注目できている

- 人間は知らないブランドならスルーしてしまう。そういう意味で機械の方がブランド識別できている

- 商品分類タスクにはimageだけではなく、ユーザーが入力するtitle,category,brand,price,color情報も使える(しかし今は主に画像のみを対象に取り組んでいる)

- ユーザーが商品画像を投稿すると、リアルタイムで画像識別して、商品の属性情報をある程度自動で入力する(入力補助的な機能)

- 出品画像を使ってtrainしているので、その画角と大きく外れる出品画像はpredictできない

- 色認識

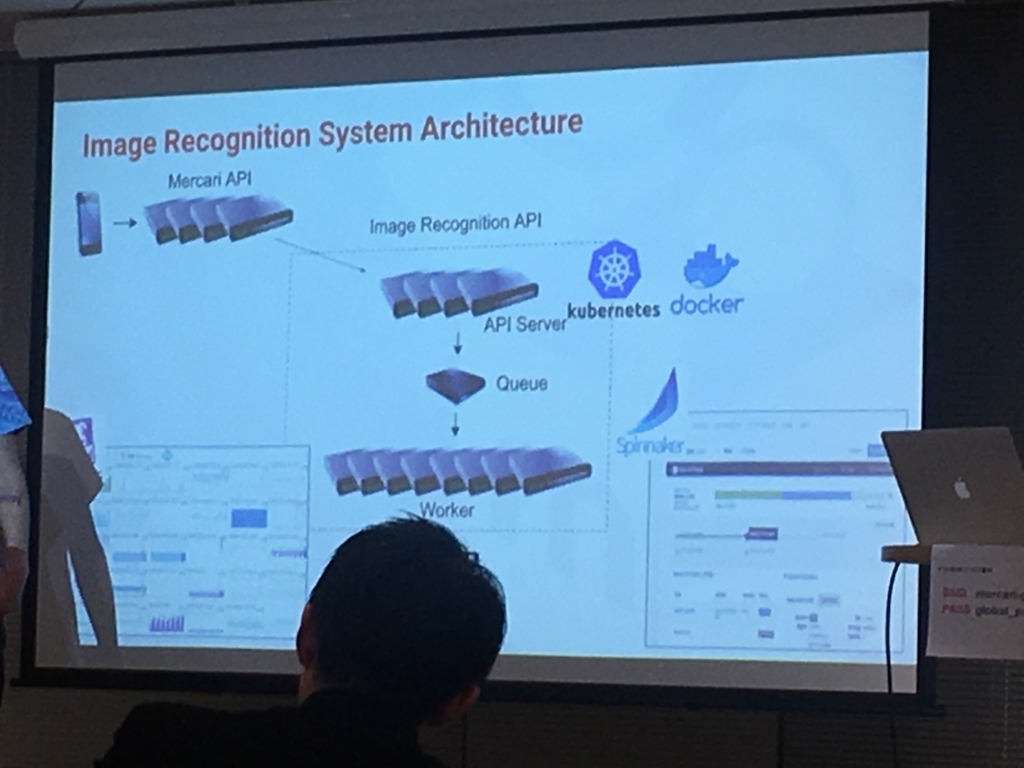

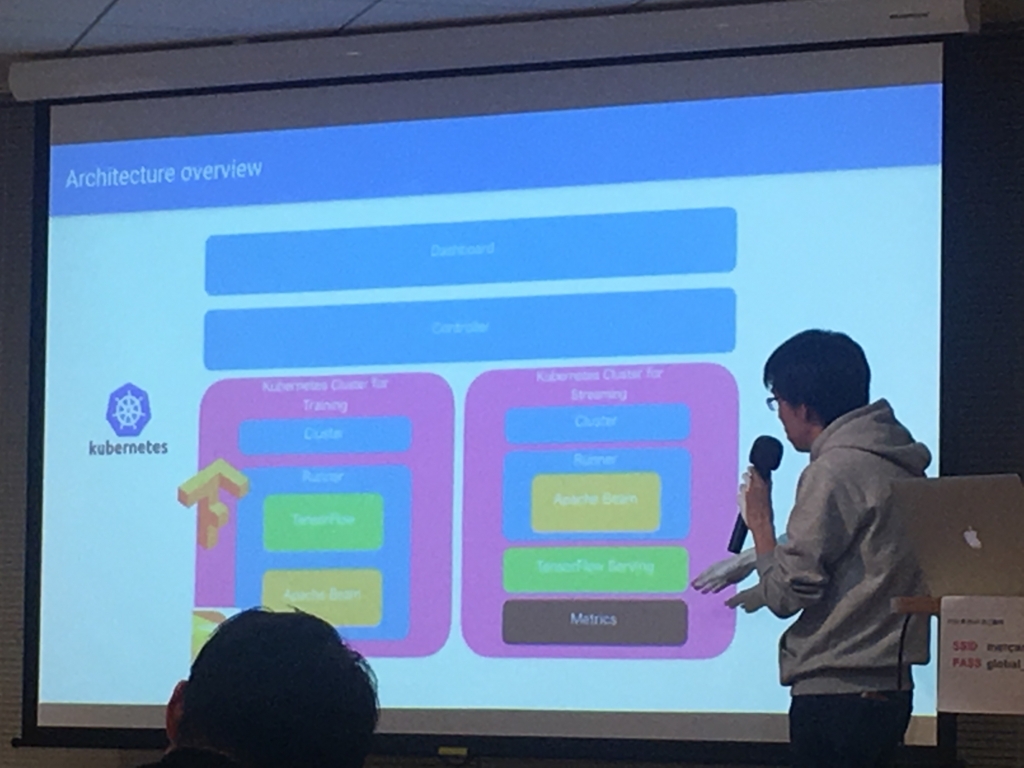

- この深層学習モデルのMLops的なこと

- kubernetes利用(いまはどこもかしこもkubernetes)

- 1日に100万品の商品が出品される。その全てに画像認識をしているが、このシステムの運用は1,2人でできている

- 深層学習モデルが走るのと、メルカリの本サービスは疎結合なので識別システムが落ちてもメルカリのサービス本体には影響しない

- 他にも、画像をクエリーにして検索する仕組みを作成中

- メルカリ技術ブログにも書いている-> 【Mercari Summer Internship】商品画像の色推定を行いました!

- 質疑

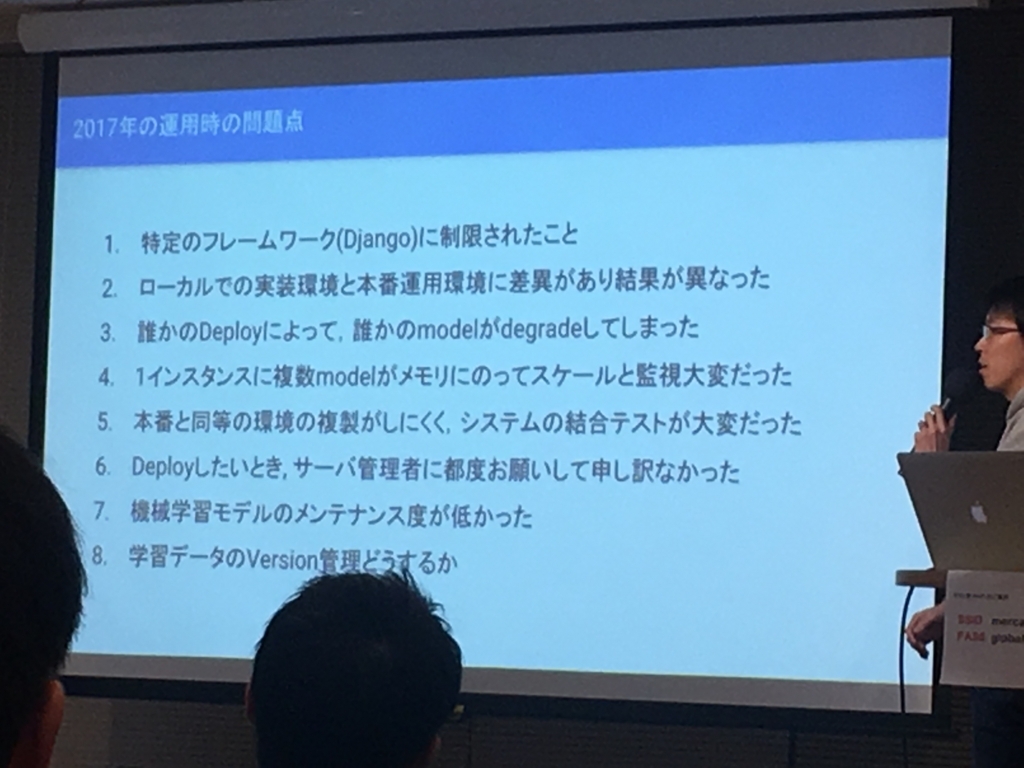

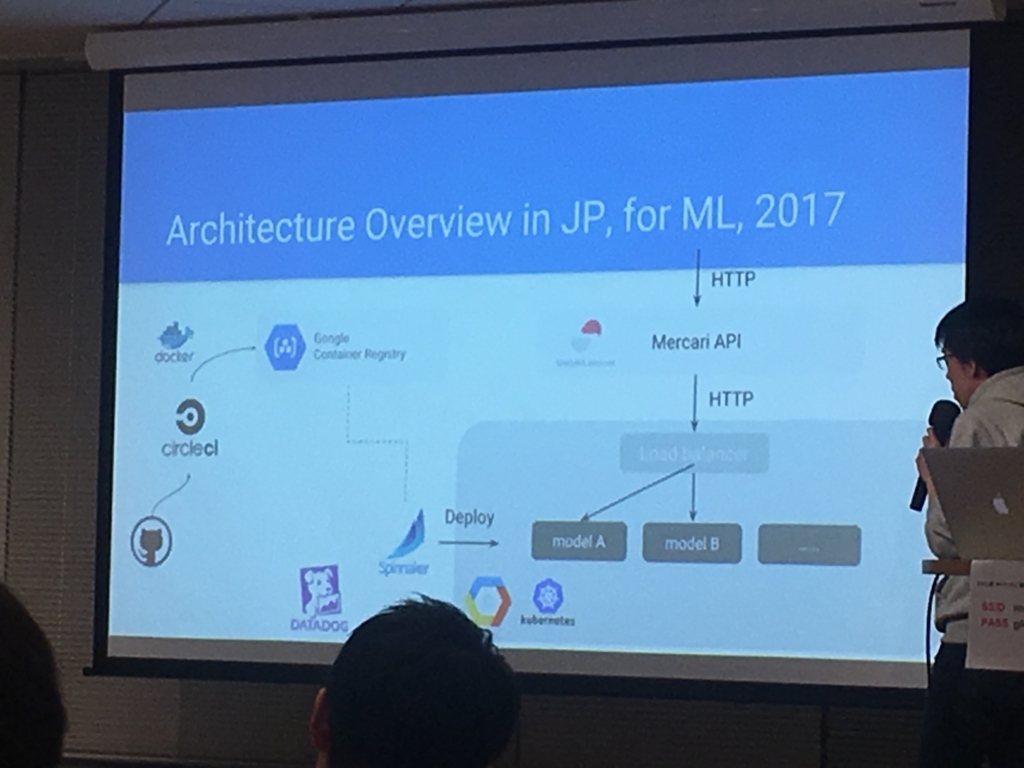

機械学習基盤(MLOps)の話

工藤さん @Hmj_kd

- MLエンジニア。物理畑の方。

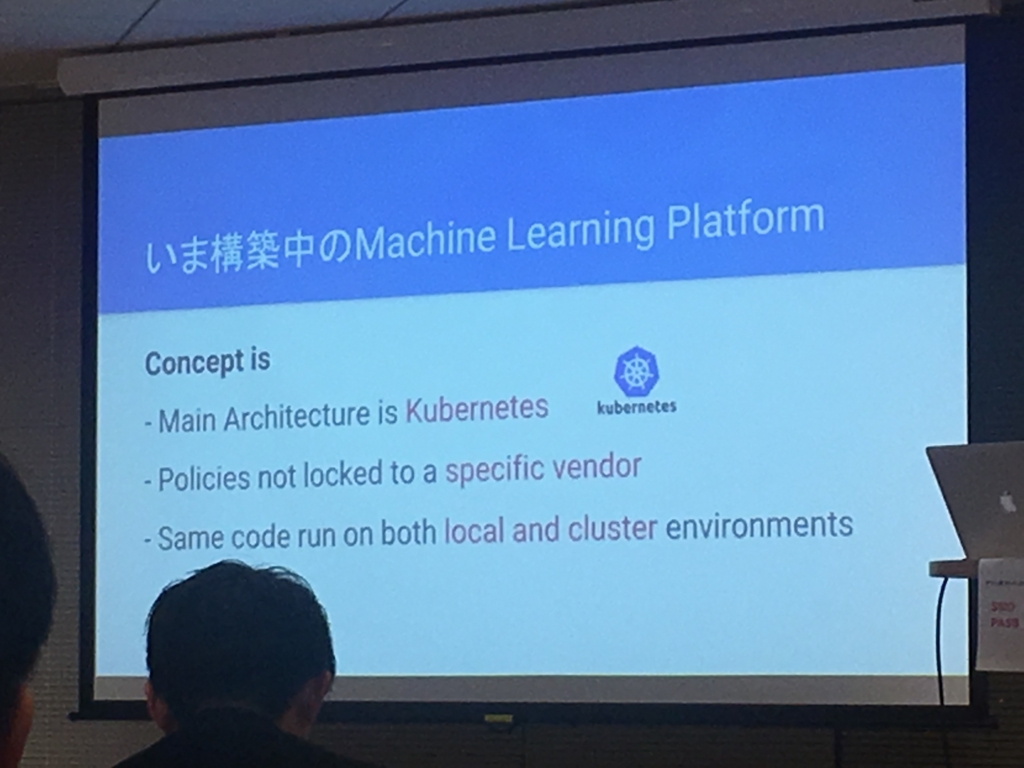

現在構築中の基盤

学習モデルのバージョン管理...気になる。 自分もシステムの話は弱いのでふーん、という薄い理解ですが、システム概要図の行間にたくさんの明文化されていないテクニックがある雰囲気

- 質疑

Q&Aタイム

- 1日で100万画像とのことだが、実際どこまでさばける?

- 1日1億くらいは現実的な時間でレスポンスできそうだと思っている

- 類似画像検索は過去画像全体にかけるのか?計算できるの?

- 直近1,2ヶ月以内に投稿された画像は検索できる。過去商品全部は無理。

- 機械学習モデルのメンテナンスについて

- 深層学習だからといって別に複雑な仕組みはいらないと思っている。別にクーロンで回してもいいし。

- 新しい商品画像に対応するため、月に1回は新規出品画像を取り込んで再学習させている

- 論文そのまま実装以外にメルカリで作った独自アルゴリズムとかもあるの?

- アカデミアとの連携とかするの?

- これからしていくよ

- 落合陽一と画像検索アルゴリズムつくったりしようとしている

- 関連商品画像の検索はメルカリにとって重要な機能なので頑張りたい

- 機械学習システム構築するにあたり、社内的な進め方は?非技術者や偉い人をどうやって説得している?

- そもそもメルカリはそういった技術に理解がある方だよ(良い会社)

- 毎回簡単なデモをサクッと作って、それを見せながら説得する。それが良い。

- 他社の事例集とかを作る。良い説明資料となる。

- あと、こまめで丁寧なコミュケーションが大切

懇親会での質問

- 年末くらいにメルカリ研究部門の立ち上げのお披露目してけどあれって何です?

- メルカリが研究開発組織「mercari R4D」を設立、シャープなど6機関とIoT技術等をテーマに事業化を目指す技術研究を進める

- 何やるのか、もう少し詳しい内容が載った最近の記事 -> メルカリが「R4D」設立で、技術基盤を強化へ――オープンイノベーションの野望はどこまで広がる?

- メルカリももっと未来を見据えた技術力を付けるための取り組み。社員の人も数日前に知ったとかそういうレベルらしい。

- 精度が下がったら再学習する、の"精度"とは何をいっている?

- その時に存在するデータ(画像)をランダムサンプルしてデータセット作って、分割したtestデータでのPrecision・Recallを見ている感じ

- 月に1回は新規画像を取り込んで再学習させている、といっていたけど、実際どれくらい意味があるの?

- 再学習によって何がどれくらい当たるようになったか、みたいな評価はしていない。新しい商品に対応するためにとりあえず回しているという感じ。

- 画像データの前処理的なことって何もしていないの?

- 何もしてない。入って来る画像が多すぎて個別に前処理することも、一律に同じ処理を行うことも不可能

- 220Mの画像でinception v3でスクラッチで学習で29%エラーってそんなもの?低くない?

- 最初にやったときはそれくらいだったけど、今はtop1を8,9割で当てられるようになった。実は画像自体はもっとたくさんある。

- スクラッチではなく転移学習でも良かったのでは?

- 画像識別の機能を導入する前と後で、出品数とかリピート数が増えたから導入に踏み切ったという感じ?

- 正直ちゃんと測ってない。画像認識による属性の自動入力機能はユーザーにとって確実にプラスとなる機能なはずなので、最初に10%のユーザーを使ってABテストして、そこで何も問題なさそうだったので一気に全ユーザーに導入した。(スピード感)

- そういうABテストみたいなことをBIチーム(データサイエンティストの部)がしてるの?

- そう。でもこの画像認識機能に関してはきっと便利なはずという確信で一気に導入した。

- AIチームに人少なすぎない?BIチームから人をひっぱったりしないの?

- 実際BIチームも全然人が足りていない。しかもAIチームの必須スキルは"エンジニアリング"でデータサイエンティストとは少しスキルセットが違う。予算がないから人を増やせないのではなく、スキルセットを持っている人が希少なだけ。

- 事業会社でMLOpsが進んでいるところどこ?

- 一番はもちろんgoogle。日本の事業会社で言うと、リブセンス、グノシー、メルカリがうまくやってると思う。

- ちなみにリブセンスさんの記事 -> Kubernetes を利用したコンテナベース機械学習基盤の構築

雑感

事業会社が自社サービスに機械学習(深層学習)を持ち込んでやりたいことは、実際はstate of the artな最高精度のDLアルゴリズムを使った機能ではなく、inceptionV3で画像分類するとかちょっとしたNLPのアルゴリズム回す、的な比較的チープ目なMLやDL。むしろ、サービス安定稼働のためには複雑で(もしくは精度改善のためのコストが高い)、挙動がやや不明な感じの最新のDLアルゴリズムなんてリスク高くて載せられないですね当然、みたいな感じでした。

機械学習基盤のポイントは、ML/DLを『全自動で』『精度を保ったまま』『動かし続ける』ことのようです。

メルカリも、一定期間でDLのモデルを再学習させるようですが、日頃の精度の監視はもちろん、精度が閾値以下 なると"自動で"再学習を始めて勝手に精度を保つようにしているそうです。

普通にできそうな気もしますが、実際は「再学習する=必ず以前より精度が上がる」わけではないので、精度が下がった時or一向に上がらない時に人が対応するのかそれも自動で何かしら対応させるのか、そもそも良い悪いといっている”精度”は同じ定義を使い続けていいのかなど判断と試行錯誤が難しそうです。

安定稼働させるためのエンジニア力と、学習モデルが意図通り正しく(将来的にも)動き続けるかを判断するMLの知識を併せ持つ人材は実際レアなので、どちらか一方のスキルを持つ人を社内で育ててMLエンジニアにジョブチェンジさせるか、いやそうは言っても難しいよね実際、みたいな話題も懇親会でされていました。(データサイエンティスト獲得競争よりも、いつの間にかMLエンジニア獲得競争の方がニーズが大きくなっている...?)

そんな中でも少人数で既に(改良中であっても)基盤を作り、しかも既にサービスとして実稼働しているのはさすがメルカリさん。次のエンジニアリングのトレンドはこのあたりなんでしょうか。勉強すること多すぎるんやで...

(なにこれすごい)パンの画像認識

twitterに流れてきた興味をそそられる画像

道の駅にあったパン屋さんが想像をはるかに超えてハイテクで、画像認識でお会計だった pic.twitter.com/WFI6SnV591

— いもす (@imos) 2017年4月8日

レジの写真に ”BRAIN” とデカデカアピールされているのでググってみたら

「世界初!カメラで会計 Bakery Scan」という製品らしい

このウェブページの新着更新は2013年から始まっているので、つい最近のものというわけでもないみたい。全然知らなかった…

実際、識別のアルゴリズムどうなっているのだろう。地味に不思議。

深層学習使えばきっとできるんだろうけど、パンの新作出るたびに学習し直す手間かけるはずないだろうし。

そうするともっと単純な物体認識でやっているのだろうけどじゃあどうやって?

そんなことをつぶやくとフォロワーの方に以下のリンクを教えてもらった。

ちなみに記事の日付は2016/5/31なので比較的最近ではある。

こちらのインタビュー記事を読んでみると、やはり深層学習は使ってないような口ぶりに思える…(明言はされていないので不明。)

Q 現在多くの会社が画像認識のシステム開発に取り組んでいますが、御社のシステムは他社に比べどのような特徴があるのでしょうか。

A:曖昧な物体の画像認識という分野においては、昨今ディープラーニング(深層学習)を用いたものが注目されていますが、高性能なコンピューターを要することや、初期学習に多くの時間を要することが製品化の妨げとなっているのも事実です。

パンの個体差(焼き上がりのゆらぎw)を深層学習以外の方法で吸収しているのならば

、そして学習の簡便さまでアピールしていてますます謎が深まる。気になるなぁ。面白い。

ベーカリースキャンに内蔵する弊社の画像識別エンジンは、初期学習に要する時間が劇的に短く(アルバイトスタッフが1商品あたり約1〜2分で登録)、かつ、販売を続けることで更に識別精度が向上します。

学習量が不足している場合や、酷似する商品が存在する場合は、対象の商品が黄色い線で囲まれ、店員に注意を促すと共に、ワンタッチ操作で修正できるようになっており、大変利便性も高くお客様にも喜ばれています。

「仕組みがわからないけどすごいモノ」を、最近では落合陽一的にいうと「テクノロジーの再魔術化(その昔、社会に科学が浸透するさまを「脱魔術化」と表現したことの逆方向)」とかっこよく言うらしいけど、機械学習で実装された道具はこれからどんどん魔法っぽい振る舞いをしていく。

なんだか不気味な感じもするけどパン屋のレジとかなら徹底的にブラックボックスにして魔法化して、レジに縛り付けられる労働者をガンガン減らせばいいと思ってる。地味なんだけど秀逸だなぁこれ。

(追記)togetterにもまとめられていた。見た人はやはり感動するらしい。

深層学習で白血球を分類する話の和訳&要約

元ネタ:

↑の Jupyter notebook :

wbc-classification/binary_training.ipynb at master · dhruvp/wbc-classification · GitHub

元々はバイオ業界にいたので、やはり「バイオ×機械学習」ネタは気になっちゃう。

そして自分もまさにこの記事のトピックになっている "顕微鏡での細胞数カウント" という苦行に苦しめられた一人なので、それを深層学習(CNN)で突破するよという話は心が躍る。

というわけで日本語要約とコメントなど書いてみました。

目的

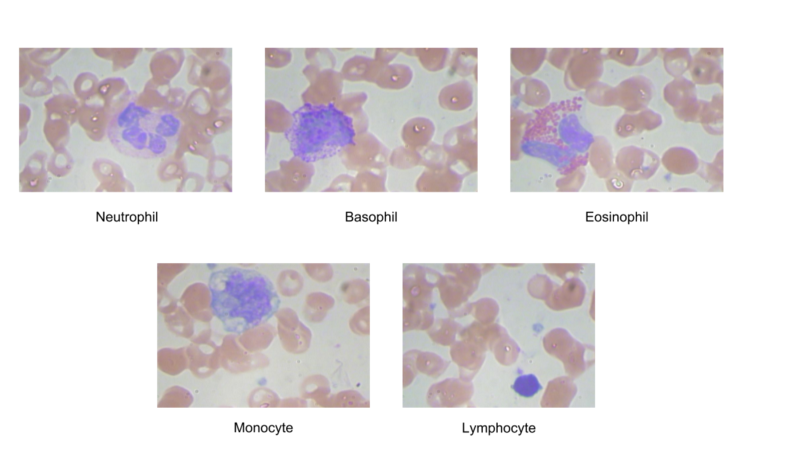

- 血液中を流れる細胞を種類別に分類したい。対象は以下の5種類の白血球のクラス分類。(しかし最終的に行っているのは2クラス分類(後述))

- 白血球は "体の防御機構として働く細胞" のこと。体に細菌やウイルスが侵入したとき、これらの細胞が増えて外敵に対応する(=免疫機構)

- 白血球には以下のようにいろいろな種類があり、そしてそれらが今回の分類対象となっている

- たしかに見た目が違うのでCNNで分類できそうではある

※1. 和名についている「好」というのは "色素で染まりやすい" という意味

※2. 好中球・好酸球・好塩基球の核(DNAが含まれる領域: 以下画像中の濃い紫色の領域)は、いくつか繋がったように見えるので"多形核白血球"ともいう。ただし核を複数持っているわけではない。(参照)

正直、「核のタイプ」の見分け方はよくわからない。おそらく、染色された箇所が一つの細胞内に複数あるように見えるのが "多形核"、一つだけのようにみえるのが "単形核" かなという感じ。各白血球のタイプでどんな働きをしているのかも気になったのでwikiから引っ張ってきてまとめてみた。

なぜ白血球のタイプを分類したいのか?

血液中に流れるそれぞれの白血球タイプの数によって健康状態を定量化できるから。

例えば、病原体に対する防御の働きをする白血球が通常状態よりも増えていると、何らかの病原体が体のどこかで悪いことをしている可能性が高いことがわかる。

また、上記のどのタイプの白血球が増えたかによって、どういった外敵が入ってきたかを予測することができるので重要な情報となる。

今まではどうやって分類していたのか?

記事によると、「機械を用いた方法」と「人力でカウントする方法」をやっているらしい。

機械を用いた方法

機械的な方法だと、血液を機械に流して、

- 細胞がチャネルを通過するときの電流の変化を測定する。電流は細胞のタイプの形状およびサイズに比例して減少するのでそこから類推する。

- レーザーを当てたときの光の屈折率で各白血球タイプを類推する。

(詳細は元記事を参照してください)

人力でカウントする方法

文字通り、顕微鏡を覗いて細胞数を根性でカウントする。

お察しの通り、この作業が非常にツライ作業だったりする。

顕微鏡を覗き込んで、見えている範囲内の(目的の)細胞をひたすら気合で数える。カウントする道具は自分の目と、交通量調査とか鳥をカウントする時に使うあのカチカチするやつのみ。最終的には「面積当りで●カウントだから、このプレートの面積に拡大すると~~」という大雑把な方法で全体の存在個数を類推する。

大抵の場合、カウントしたい対象(細胞とか微生物とか)は時間が経つと増殖したり死滅したりして、カウントしている間にも増減するのでとにかく迅速にカウントしなければいけない。サンプル数が多い時は一晩かけて気合でやったりするのでドライアイになること必死。白血球など静的な対象ならまだマシで、能動的に動き回る微生物のカウントは何らかの工夫を凝らさない限りツライことになる。

ただ、こんな単純な作業でも専用の機械を買おうとすると目玉が飛び出るほど高い。最近では趣味の人達が自作の細胞カウンターを作ってクラウドファンディングで資金を集めたりもしている。

機械コスト的にも人力作業のコスト的にも、深層学習を使ったモデルで簡単に・精度良く・お安くできるようになれば嬉しことは間違いない。

利用したデータセット

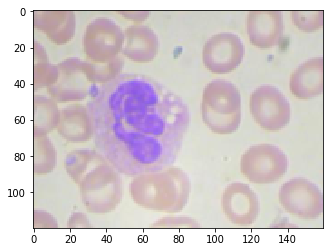

白血球だけ染色した画像が352枚。画像サイズは640×480。

352枚って、えらいサンプル数すくないなぁ、という印象。

(白血球を染色した画像例↓)

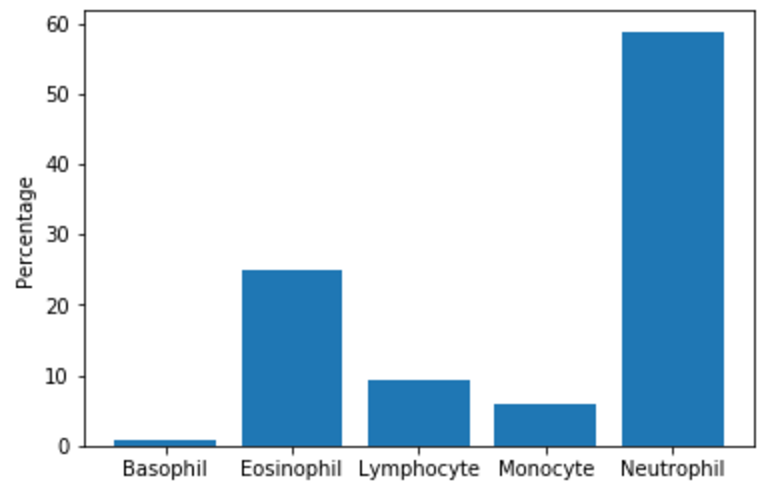

白血球のタイプごとにカウントも実施し分布を調べる。← 専門家が分類を判断しカウント(正解データ)

Basophil(好塩基球)が最も存在数が少なく、Neutorophil (好中球)が最も多いらしい。

実施した画像の前処理

深層学習のモデルに突っ込む前に、画像に対して以下の前処理を行ったらしい。前処理大切。

- 一枚の画像に複数の染色された細胞が映っている画像は除外

- Basophils (好塩基球)は絶対量がそもそも少なかったので今回の分類対象からは除外

- 画像サイズを120×160にダウンサンプリング(学習スピードアップ!)

- ラベルの変更。好中球・好酸球 → 多核、単球・リンパ球 → 単核。つまり、5クラス分類問題からバイナリ分類問題に変換。(最初とだいぶ話を変えたな...)

- Image Augumentationを行い、訓練画像データを 2500枚*4種類 (= total 10,000枚) に増やした

- ピクセルの値を 0~1に正規化

モデル

CNN部分は単純なLeNet構造をKerasで実装。(input_sizeのデータ形式を見る感じ、バックエンドは tensorflowではなく theano?)

パラメータとして、

- エポック数: 20, バッチサイズ: 32,

- レイヤー数: 3, フィルタ数: 32 (最後のレイヤーは64), カーネルサイズ: 3*3, 活性化関数: relu (最後はsigmoid), loss関数 : binary_crossentropy

- Dropoutを0.7入れる

学習には、訓練画像281枚(元の画像データセットの80%相当枚数)をImage Augumentation(rotations, shifts, zooms)で増やしたものを使い、Amazon P2 インスタンスで学習を実行

以下CNN部分のスクリプトのみ抜粋

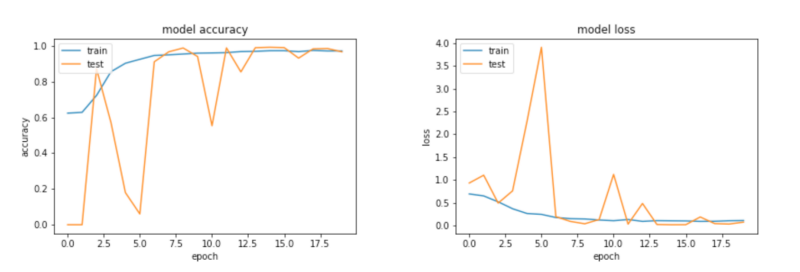

結果

元の訓練画像データセットの20%に当たる71枚の画像をvalidationとして実行し、accuracy 98.6%を得た。精度高い。

本当は多形核なのに単形核と予想したサンプルが1つだけあった。ちなみにその間違えた1つの画像が以下。人間が見ても判断が割れそう

結果に対する注意書き

- 今回使用した訓練画像データセットは均一な環境で撮影した少数サンプルのものであるので、本当は細胞の形態や照明条件など多様な条件下で撮影した画像をもっと含めるべきだった。そうするともっと汎化的なモデルができるはず。

- 同モデルを、最初の5クラス分類問題として同様に実行すると accuracy は86%となる。多クラスをうまく分類するにはさらに工夫が必要らしい。

やってみたけどうまくいかなかったアイデア集

「実は他にもいろいろなアイデアでやってみたんだけど結局 精度アップには繋がらなかったんだ。そしてそれこそ共有すべきだと思うからそれも一緒に書いとくね」、とのこと。素敵。

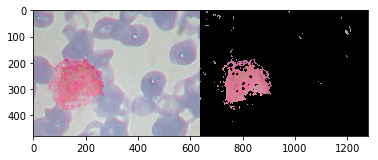

染色された細胞核だけマスクして、その画像をCNNにかけてみた → 精度が88%に低下

- つまり、核の形状以外の余分だと思われる情報を落としてCNNしてみた、ということ

- なぜダメだったか?

- 指定したカラーマスクのレンジが、照明条件の違いによってデータセットの全ての画像をうまく一般化できてなかったっぽい

- 細胞のタイプを予測するには核の形状以外の画像情報(細胞質とよばれる核以外の細胞構造)も重要っぽい

(左が元画像で、右がカラーマスクによって染色した核領域だけ取り出した画像)

学習データセットをクラス分布を維持したままImage Augumentationしたらクラスの偏りが強すぎてうまくいかなかった → 学習データセットをクラス間でバランスさせるとうまくいくようになった

- 元のデータセットでは多形核細胞の存在個数の偏りが強く、数が少ない単形核細胞ではrecallが低くなった

- なので、元の分布に関係なく各クラスで2,500枚ずつAugumentationした画像を学習に使った

VGGNetを使って転移学習しようとしたけどうまくいかなかったよ → さすがに"白血球"の画像の分類には特徴として貢献しなかったっぽい

VGGNet with ImageNetを使っても多クラス分類問題はうまく機能しなかった

- バイナリ分類問題では上記のLeNetベースのモデルと同程度の精度をだすけど、他クラス分類問題はうまく機能しなかった

- なので、よりシンプルなLeNetでやっぱり良いよね

結論

- LeNetのような簡単なモデルでも(バイナリ分類問題だけど)精度良く分類することができたよ

- 本当はもっと汎化的なモデルとなるように、多様な条件下で撮影した画像を含めるべきだと思っているよ

- 白血球だけでなくその他の血中細胞やガン細胞にまでもこのような技術が使えることにエキサイトしているよ

NAKEDのプロジェクションマッピングのアート展を見てきた

ある日、SNSを見ていたらこんなツイートを見つけた。

#SWEETSbyNAKED のしゃべるプロジェクションアイスクリーム! pic.twitter.com/eTvbgCrAZU

— 池澤あやか / いけあや (@ikeay) 2016年12月28日

アイスクリーム(食べ物)にプロジェクションマッピングしているのを初めてみたので個人的にはかなり衝撃的でした。天才の発想やで...

ということで、さっそく展示を見てきた。

クリエイティブカンパニー NAKED(ネイキッド)

メディアアートといえばチームラボやRhizomatiksなら知っていたけど"NAKED"は知らなかった。と思ったら1997年からある "創業20周年を迎える老舗クリエイティブカンパニー" だそうで...。(ただの不勉強)。

代表 村松さんのインタビュー記事などもたくさん出ている。イケメン。

- 『by NAKED』は、品質保証の一部。代表 村松亮太郎が語る理想のクリエイティブチームとは 株式会社ネイキッド

-

村松亮太郎 公式ブログ Powered by LINE (作品の写真がたくさん見れる)

"NAKED"という名前を知らない人でも、2012年に行われた東京駅のプロジェクションマッピングなら知っている人が多いかも。あれを作ったのがNAKEDだそう。

SWEETS by NAKED

で、冒頭の話題に戻ると、展示を見てきたのがこれ。

開催は2016.12.1~2017.1.9 @表参道ヒルズ だったのもう終了済みだけど。

クリエイティブ集団NAKEDが贈る最新作は、“SWEETS”がテーマ。

プロジェクションマッピングやセンシングのテクノロジーによって、

映画のような世界が目の前に現れます。

表参道ヒルズの近くにもあるスイーツショップも参加し、展示されているスイーツは一部本物もありました。

会場内は意外に狭かったですが、ディズニーランドのような非日常空間に仕立てていて、仮装したスタッフさんが楽しげに賑やかしをされていました。

インスタグラム見ると分かる通り、かなり女子力高い感じ。

自分のような"デジタルアート"に興味ある人も行っているのかと思いきや、カップルと女の子グループばかりでした…orz

いろいろ撮ってきた動画を貼ってみる。まずはエントランス。

プロジェクションマッピングって、どデカい建造物とかにざっくり映像を照射するものだというイメージがありましたが、実際に見てみると、こんなに細かく、詳細に、鮮明に投影できるもんなのかーという驚きが大きかったです。

動画に映ってるのは、ディスプレイとかじゃなく、ただのパネルと小道具に映像を投影して被せてるのですが、一見すると元々そういう色のパネルか液晶ディスプレイかなって思うくらい鮮明でした。

最近 MicrosoftのHoloLensが購入者に届き始めて、その衝撃的なリアリティーのAR画面がSNSでも拡散されてますが、このレベルの鮮明さのプロジェクションマッピングがもしもディスプレイデバイス無しで空間上にも投影できるようになれば確かにデジタルとリアルの見分けが単純にはつかなくなりそう。それくらい鮮やかなプロジェクションマッピングでした。

会場中の他のいろんな立体物にもマッピングされてた。天井からは何台のプロジェクターが吊り下がっていたのか… (わざわざ上を見上げて注意してみない限り、プロジェクターの存在は気にならない)

狭い空間なので、プロジェクターと照射対象の間を人が横切ると影ができて不細工な感じになるかと思っていたけど、そんな嫌な印象は全然なかったです。やはりうまいこと配置されているのですね。

たまに一定間隔でスペシャル演出タイムみたいなのがあり、そのときは会場にある全て(?)のプロジェクションマッピングが会場全体を使って一つの演出をしていました。

ただ単に投影しているだけではなく、来場者とインタラクションするマッピング演出もありました。

これは来場者の影に反応して、降ってくるスイーツが弾き返されるような演出を作る展示(しかし特にそれ以上の何かはなかった)

最後にも書いていますが、プロジェクションマッピング自体は結構単調で、カップルで来てもすぐに飽きちゃうのではと思っていたが、入場料とは別売りのチケットを買うと冒頭のしゃべるアイスクリームの展示で実際にアイスを買って食べれたり、チョコレートで指輪が作れるスペシャルエリアもあって楽しそうな感じでした。(というより、この展示はそもそも自分のようなのはターゲットにしていないのですよね…)

TOKYO ART CITY

NAKEDが手がけた別のプロジェクションマッピングの展示が同期間に渋谷ヒカリエでもあったのでその足で一緒に見てきた。

今度は "SWEETS"ではなく、"CITY"がテーマ。

こちらもヒカリエでの展示は既に終わっているものの『二倍のスケールになって東京ドームシティで6月に開催!』らしいです。

巨大模型による『TOKYO HIKARI VISION』の再現を中心に、ランドマークなど東京を象徴する場所を模型によってコラージュし、その中を通り体験することによって時間軸を超え変化し続ける“都市”を体感するアート展です。人の営みが集積する都市の街並みに、建築物・光・映像・音、時間軸を超えた空間が広がります。

こちらも撮った動画をペタペタ。

会場入り口に飾ってあった渋谷駅周辺模型へのプロジェクションマッピング。

ビルの一つ一つに別のプロジェクションを当てて見せ方を調整していて、芸の細かさにびっくりする。

会場入口の雰囲気。

床に"TOKYO ART CITY"の文字、天井には無造作な感じで看板が吊り下げられててサイバーパンクな街の入り口っぽくて非常にかっこよい。テンション上がる。

会場の中のメイン展示は、2012年の東京駅プロジェクションマッピングを彷彿させるミニチュア版東京駅の模型(といってもデカい)にダイナミックなマッピングを行ったもの。

演出の一回分が長く、どんどん移り変わっていくマッピングをぼーっと眺めていると、投影面積も広いせいか、自分がVRの空間に入ったような感覚になります。

実物の東京駅マッピングもかっこよかったけど、閉鎖空間(部屋の中)で360度プロジェクションマッピングされた場所での没入感的なものはやはりまた違う印象を受ける。ちょっと映画館っぽいかも。

感想

自分が想像していた以上に精細で緻密なプロジェクションマッピングだったので「驚いた」というのが一番の感想。

VR・ARの次に来るであろう現実空間への(ヘッドマウントディスプレイ無しの)投影、つまりホログラム的な技術はこの延長線上にあるのだろうか。

ただ、一定時間で延々と同じ映像をリピートして照射しているだけなので5分も見てると飽きる、とも思った。映像作品的でもあるので、あまりユーザが割り込んでインタラクションできるものでもないし…。

コンテンツに関しては機械学習的な手段で自動生成して動的にどんどん投影内容を変化するようにできたりしないのかな、どうなのかな、個人的に興味ある。

今度は2月に花を題材にした"FLOWERS BY NAKED"があるのでそちらも見に行きたい。

【ネタバレ注】『AIの遺電子』という漫画が好きすぎるので勝手に解説していく(1巻・2巻)

職業柄、人工知能に関する話題を見聞きしたり考えたりする事が多いのですが、そんな話を知人とする時に必ずおすすめしているのが『AIの遺電子(あいのいでんし)』という漫画です。人工知能に関して知識がない人でも簡単に読めて、でもストーリーは深いという秀逸な漫画です。今はAI好きな人達の間で話題のようですが絶対にもっと流行ると思います(夜中の放送枠で実写ショートドラマシリーズ化とかになりそう)。(追記:と思っていたら今年の『このマンガがすごい!2017』のオトコ編14位に入ってたのですね!)

ざっくり言うと、「人工知能専門医ブラックジャック」的な漫画です(ブラックジャックは読んだことないんだが…)

『人工知能・ヒューマノイドが当たり前に存在する社会になったらこんな問題が起こるよね』という話をこれでもかというくらいリアルに、細かく、引き込まれるショートストーリーで読める漫画です。「人工知能が完成したら人間が滅ぼされるんでしょー」とかしか言えないおっさん方はぜひ読むべきです。

医師である人間の主人公とその助手のヒューマノイドのヒロイン(?)というメインキャラとメインストーリーがあるものの、基本は短いオムニバスストーリーになっているので途中からでも読みやすいです。

深い問題提起をして唸らせられる回もあれば、ほろりとする回もあって読み始めると時間を忘れて引き込まれます。短編小説を読んでいるような気分。

専門知識もいらないので「人工知能、気になってるんだよなー」みたいなライトな人も勉強も兼ねて気軽に読んでみてはいかがでしょう。

以下の世界観の設定さえわかっていれば楽しめます。

人間…普通の人間。しかしインプラントなどで部分的に機能拡張している人間が多いという設定らしい(攻殻機動隊でいう「電脳」的な感じっぽい)

ヒューマノイド…人格や心を持つほぼ人間と違わないAI。イメージ的にはドラえもんや鉄腕アトム的な感じ(しかし体は代謝機能を備えているのでもっと人間に近い)。

人間と同じ権利も認められいるし、人間と結婚することも出来る(しかし人間との間に子供を作ることはできない)。

頭を損傷しない限りは死なないらしく、体は代用可能。しかし人格のコピーを取ること(首より上をイジること)は法律で禁じられているという設定。”ロボット”とは明確に区別されている。瞳の形が違うので、一応外見で人間かヒューマノイドかを識別することができるという設定。(商業用)ロボット…特定の産業や目的に特化された存在であり産業機械的な立ち位置っぽい。ヒューマノイドが持つような権利も無いらしい。しかしヒューマノイドの脳構造の知見を活かして製造されているため人やヒューマノイドに近い振る舞いはできる。人間やヒューマノイドには「心」があるが、ロボットには無いよね、という区別があるらしい。

このエントリーでは、それぞれのストーリーにおける主題について言及したつもりなので激しいネタバレは無いはずですが、まっさらな状態で漫画を楽しみたいという人は読まないほうが良いかもです。

ではストーリーです!

第1話 バックアップ

自分の人格をコピーして「もう一人の自分」が出来ることに対する問題。つまり「私とは何か」という同一性やアイデンティティーに対する問題について。第1話目にこのトピックをもってきた時点で、「この漫画は絶対に面白い」と確信した大好きなお話。

自分の分身ができるなら良いんじゃない?と思うが、『地球上のどこかに自分と全く同じ容姿・記憶の人間が仮にいた場合、そして相手が自分を殺しに来たときでも、全く同じ”自分”がいるのだから自分自身は死んでもいいと思えるか?』という問に対しても同じ回答ができるかどうか。漫画「亜人」でも不死の人間が脳を破壊されたあとに再生される自分も”自分自身”と言えるか?そこでは”スワンプマン”が引用され、また、攻殻機動隊でも”ゴーストダビング”として同じ内容に対する問題が引き合いに出されている。「AIの遺電子」でもヒューマノイドの人格コピーは法律で禁じられている設定になっている。この後の話にも断片的に出てくるが、どうやらこの第1話のこのトピックが主人公の医師の過去に関するメインストーリーにも関係しているっぽい。

第2話 かけそば

人間とヒューマノイドの違いやその限界について。「人間の芸」である落語家を目指すヒューマノイドが、自身が本物の人間でないので”本当の落語”なんか出来っこないと葛藤する話。オチが秀逸。

『真実味ぃ?知ったような口きくんじゃないよ!いっぺん死ななきゃ幽霊役は出来ないってのいうのかい?』というセリフが好き。

第3話 ポッポ

「心とは何か」について。人工知能が発明・発達し、人間の脳機能の多くが理解されたとしても「心」とは何かを理解するにはもっともっと先なのかもしれない。ヒューマノイドや人間の「心」に関するストーリーはこの後も何度も登場する。

『そもそも心なんて誰にもないかもしれんぜ』

第4話 恋人

人間とヒューマノイドの恋について。「AIの遺電子」の設定では人間とヒューマノイドの間には子供は作れず、養子縁組で人間orヒューマノイドの子供を迎え入れて家族になるという設定(リアルの世界もそうなるだろうなぁ)。人間とヒューマノイドの間の”当たり前”と思う価値観は異なるはずだが、種や理屈を超えて同じ感情が湧き上がることもある、という話。

第5話 富豪の秘密

記憶能力を拡張し、全ての記憶を保持することができるヒューマノイドの苦悩について。

誰もが考えたことがある「見聞きしたもの全てを記憶する能力」をもし人工的に獲得するとどうなるかというストーリー。脳が本来持つ「時間が経つと忘れる」機能は我々が考える以上に重要で、神秘的で、軽薄で、適当で、しかしかけがえのないもの。

第6話 ベスト

第2話に似た人間とヒューマノイドの違い・限界・葛藤について、そして友情。自身の体について「性能を制限された機械の体には限界がある」とふてくされるヒューマノイドの話。ここでは「人間」と「ヒューマノイド」の対比だが、リアルの世界の人間同士であっていろいろな理由をつけて人間は「出来ない理由」を探している。人間とヒューマノイドならその意識(言い訳)の溝はますます深いものになるだろう。

『人間もヒューマノイドも怠け者だからな ベストを尽くすってのは至難の業だ』

第7話 ピアノ

人間の情緒について。人間は激情的に情緒が変化するが、それは見方によっては「個性」かもしれないし「治療すべき精神疾患」なのかもしれない。それらがプログラマティックに制御可能になる技術が確立した時、それでも人間は不安定な情緒を「個性」としてポジティブに受け止め、「治療しない」という選択をすることができるだろうか。

第8話 ミチ

「機械はただの道具であるか?」という問。主題は、「いや、人間は機械をその価値以上に認識している(認識してしまう)」という反語。作り物のおっぱいにも男性は生理的に反応してしまう、人と機械に対する認識の切り分けはそう簡単にできない、という話。主人公の医師の過去に言及するメインストーリーの一つにもなっている。

第9話 夢のような母性

AI社会における心の怪我とそのケアについて。AIによって人間やヒューマノイドは心理状態さえも詳細に観測・解析されるようになるのであれば、それをケアする最善の方法もAIによって提供される。AIは人間の心理士よりも正確に、早く、安全にケアをすることができるが、そんな「夢のような解決法」に頼りきって良いのだろうかという問題提起。ここでも「心」がテーマになっているような気がする。

第10話 海の住人

人間そっくりに作られ、人間社会に生きるように強制されるヒューマノイドの苦悩について。人間同士でも社会に馴染めず”引きこもり”、”一匹狼”や”アウトサイダー”になる人がいるのだから、人間として生きることに疑問を持つヒューマノイドはリアルでも現れそう。そんなお話。

『人間をそっくり真似るなんて、機械にとっては随分無駄なことだと思わない?』

第11話 寡黙な彼女(ここから第2巻)

体と心のチグハグ差について。事故によってまともに喋ることも出来ない不便な体になったが、逆に互いの気持ちを読み取りケンカもしなくなって関係が良くなったカップルの話。もしくは「制限があるからこそ本質が見える」というような話にも思える。

『口が回りすぎるとさ キャッチボールじゃなくてドッジボールになっちまう』

第12話 俺の嫁

ヒューマノイドに似せた商業用恋人AIの愛や恋の話。恋愛状態やそれにまつわる行動を”人間と同じように”精度良く再現するロボットがいたとして、そのロボットの行いはアルゴリズムによる行動だと人間は割り切ることができるだろうか。いや、きっと出来ずに人間はそのロボットに「本当は心があるのでは?」と感じ本物の恋人と同じように接するだろう。商業用恋人AIはかならず実現する、そうしたときにそれを「ありえない・気持ち悪い」と取るか、「今の時代はそういうもんでしょ」となるか、リアル世界はどちらに進むのか興味深い。

余談だが、この話に登場する「恋人ロボットに料理させるためにはそのスキルに課金してロック解除する必要がある」というプロットはエゲツないけど、リアルでも実際にそういうふうになるのだろうなと思えて苦笑してしまう。未来の課金の形。

第13話 運命の人?

好き/嫌いという感情はどのようにして生まれるか、について。

人間は知らず知らずのうちに、好きな/嫌いな食べ物、好き/嫌いな異性のタイプのように趣向が備わっていく。それはおそらく意識的に「好きになろう/嫌いになろう」としたわけではなく受けた教育や経験の中でいつの間にかそういうふうになっているもの。そうしたときに、もし他人によってあなたの「好き/嫌い」の傾向を誘導されるようなことが起これば自分の好き/嫌い判断をどのように解釈するのだろうか。いや、そもそも今の自分の好き/嫌いだって他人に植え付けられたもの(ex.昔の彼氏が好きだった音楽、など)が多分にあるはずなので、それを良い/悪いと判断すること事態が難しいのかもしれない

第14話 氷河を超えて

積み重なった時間の重みについて。事故によって時間が止まっていた男性ヒューマノイドと元恋人の女性ヒューマノイドが30年ぶりに再会する話。その間に女性の環境は変わり、元のように二人では過ごせないが、それを乗り越えまた人生を進める話。映画にありそうなプロット。

第15話 ファントムボディー

ヒューマノイドに起こる幻肢痛の話。攻殻機動隊ARISEでも「ファントムペイン」という話があったことを思い出す。

人間は物理的な体の調子としてはなんの異常もなかったとしても、精神・心理的な影響からくる不調には抗えない。(どれだけ空腹だったとしても失恋のショックで物が食べられなくなる、など)。それは機械の体を持った存在(ヒューマノイド)になったとしても同じなのだろう。ヒトは「心」というものをいつまでも完全制御できずに持て余すし、しかしそれこそがヒトという生き物だと思う。

第16話 じいちゃんのGちゃん

規定外の知性をもつAI(現行法律施工前に作られたAI)と社会の関係について。もしくは見た目だけで評価するという偏見について。

家族が大切にしていた「規定以上の知性を持つロボット」が世間(社会)に見つかってしまい、危うく処分されそうになるが、主人公医師の機転によって処分を免れロボットは家族のもとに帰ってくる。

“ロボットらしいロボット”に規定以上のAIが搭載されているのは法律違反となるし不気味に感じるが、生き物にそれっぽい知性が宿っているのは「普通」だと感じてしまう。それがたとえ両方に同じ知性が載っていたとしても。容姿を自由にデザインできる時代になったとしても、ヒトは「見た目」で判断を下し続けるのだろう。

『自由なロボより 自由な猫のほうが目立たないだろ?』

第17話 ホワイトデー

既製品と手作りの価値の違いについて。もしくはブランドやストーリーというものは人間だけが作り出せるという話。

電子メールと手書きのはがき。ビデオチャットとface to faceのコミュニケーション。口頭の告白とLINEでの告白。回転寿司と老舗の寿司屋。最終的には目的を達成する(限りなく)同じアウトプットになったとしても、それを達するまでの労力やコスト・努力・苦労などにヒトは価値を見出す(結果は大切ではない、過程こそが大切なのだ!というやつ)。ほぼすべての行為が自動化・デジタル化したとしても2/14に大好きな人には「手作りの」チョコを渡す文化はきっとなくならないように、「心を込める」行為はいつの時代でも何にも代用されずに残り続ける。

『旨い不味いでいったら何でもロボに作らせりゃ間違いないわけだ でも リサが一生懸命作ったっていうストーリーはロボットには作れない』

第18話 やり直し

結局、「人生のやり直し」なんて出来ないという話。

誰もが一度は考える「今の能力のままで、子供から人生をやり直せたら楽勝だったのに」という妄想(俗に言う『強くてニューゲーム』状態)は、ヒューマノイドになら可能かもしれない。しかし、結局自分ひとりが変わったとしても周囲との軋轢は常に生まれ続け結局はうまくいかなそう。そういう妄想は夢の中だけにしときましょうという話。

第19話 エモーショナルマシン

本当の自分の気持ちと、表面上の振る舞いを切り離すことについて。

人間でも、思っていることと振る舞いが違うこと、”ネコを被る”、ということはよくある。ヒューマノイドにおいては表情を機械的に作って人工的に”ネコを被る”ようにすることもできる(内面では怒っているのに、機械的に笑顔を作る、とか)。しかし技術的にそういう行いが可能になったとしても、心理との乖離が生まれ、やはり精神に不調をきたすようになる。わざわざ愛想を良くする、見せかけの振る舞いを良くすることを頑張らなくても、素の自分であっても、本当の自分を好きになってくれる人はどこかにいるよ、的な話にも思える。

第20話 お別れ

ヒューマノイドの死について。ひたすら悲しい話。

「AIの遺電子」では、ヒューマノイドは脳が傷つかない限り生物的に死ぬことは無いが、それでも脳の劣化によって人格が壊れ”寿命”を迎えるという設定になっている。それに対して”延命治療”も行えるが、裏を返せばヒューマノイドは人間以上に「死ぬ時期」をコントロールすることができるということ。ヒューマノイドとしての人生をいつ、どのように終わらせるか。死ぬ時期に対しても意思決定を求められるようになったとき、何を持って「自分の人生はこれで満足したのでここで終わらせよう」と決めることができるのだろうか。現代の日本でも終末医療や”終活”が話題になることがあるが、考えたくないが、考えなければいけない問題である。

第21話 シャロンとブライアン

人間・ヒューマノイド・商業用ロボットそれぞれの命の重さについて。

統計やデータ分析業界では有名過ぎる”Titanic”のデータセットでも自明であるが、タイタニック事故における高級な客とそうでない客の死亡率には明確な差があった。命の意思決定をするときでさえ、人は考える以上に人間を”区別”して取捨選択を行う。この話での”区別”は、人間>ヒューマノイド>商業用ロボットの順に命の重さを測られた。これは漫画の1ストーリーではあるが、トロッコ問題のようにリアル世界でも今後必ず顕在化するはずの考えるべき問題となる。

感想

そもそもなぜこの漫画がこんなに好きかというと、「とにかくリアルなところ」ということに尽きます。

今まで、「AI」が登場する近未来SF的な漫画はどこかしら突っ込みどころがあってそれが気になってしまうということがありました。

例えば、自分は『PSYCHO-PASS サイコパス』というアニメも大好きで、設定に登場する「スパコンが人間に”神”のお告げを出して行動を管理する社会」的なプロットは「そういうことも起きそう(というか既に社会の一部はそうなっている)」と思えます。

しかし、「(まだ犯罪などを犯していない場合でも、)心理状態や性格傾向を計測して将来的に犯罪を犯しそうな人を取り締まる」というプロットはちょっと行き過ぎているというか、「そんなことほんとに可能か?」と引っかかってしまうところがあります。

それに対して、「AIの遺電子」は、製作チームにAIや脳科学・人間倫理に詳しい人がアドバイザーとして入っているの?、と思える程に今後の社会にまさに起こりそうな具体的な話がふんだんに盛り込まれているように感じます。

個人的にグッと来た設定は、“超高度医療用AI”という存在を「治療は成功するかもしれないがその治療過程などは人間の解釈が難しい。コミュニケーションをとりながら納得して治療する、人の手による解決を希望するなら良い医師を紹介する(第3巻より)」的な説明をして位置づけているところとか、まさに医療AIと人間の医師の関係はそういうふうになるのだろうなと思えるところとかです(細かい)。

ドンパチこそ無いものの、攻殻機動隊のようなストーリーが好きだという人は好きな漫画になると思います。

2巻までの21話の内だと、個人的に好きだったのは

・第1話 バックアップ

・第20話 お別れ

です。

両方共使い古されたプロットだし、第20話はドベタな感じですが、他のストーリーの後でみると一層現実感や悲壮感が増すというか、このタイミングでずーんとくる話は心に残ります。

この漫画全体として、「人間とヒューマノイドの種としての差」そしてそこから生まれる「葛藤や偏見」、ヒューマノイド(AI)という存在によって顕在化した「人間とは何か」「心とは何か」「生きるとはなにか」という哲学チックな問いが全ての話に横たわっているのがストーリーに厚みを出しているように感じます。(そして、その合間にちょこちょこ登場するヒロイン(?)のリサに癒やされる。主人公の仕事をサポートする超高度医療AI“ジェイ”もなんだか好きなんですよねー。ジェイを敢えて擬人化せず、amazon echoのような無機質なインターフェイスにしているところもなんだか逆に好印象な感じです)

絵も、ストーリーも、読後感も、ボリュームも良い感じな漫画に久々に出会えて嬉しいです!

3・4巻ももちろん読んでいるのでいつかこの続きを書きたいです。

その他のブログ

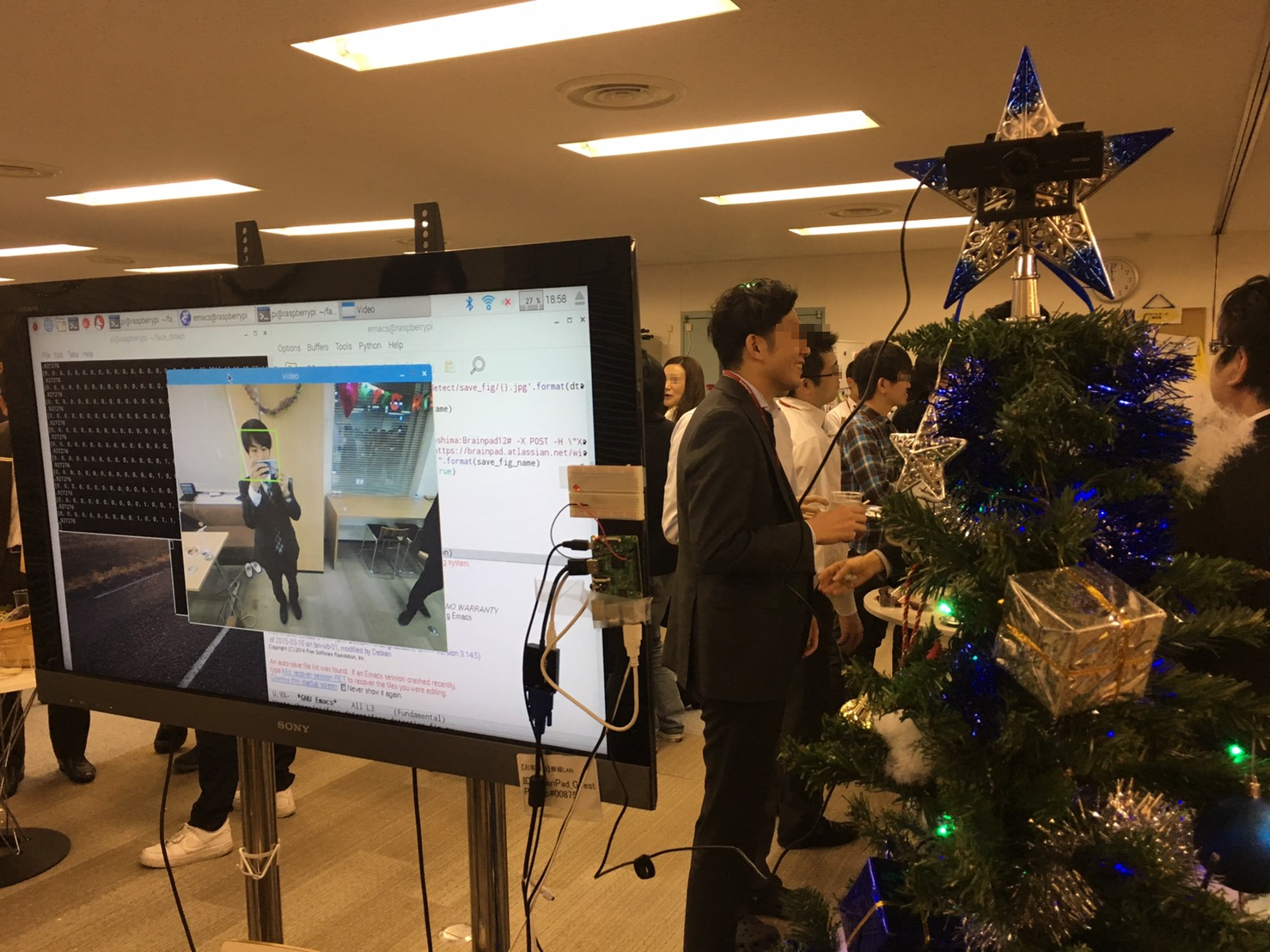

RaspberryPi3+OpenCVで顔検出して自撮りしてくれるクリスマスツリーを作りました

お前がクリスマスツリーを眺める時、ツリーもまたお前を眺めているのだ - ニーチェっぽい誰か

ということで、

会社のクリスマス会用のネタで、RaspberryPi3+OpenCVで顔検出してセルフィーを撮ってくれるおもちゃを作りました。わりと盛り上がったのでめでたしめでたし。

こんな感じでリアルタイムで顔検出してくれます。

RaspberryPi3といえど、単純に顔検出をリアルタイムで行おうとすると処理が重くてカクカクしちゃうので少し工夫した点などメモしました。

Enjoy!

BUFFALO 200万画素WEBカメラ 広角120°マイク内蔵 ブラック BSW200MBK

- 出版社/メーカー: バッファロー

- 発売日: 2016/10/07

- メディア: Personal Computers

- この商品を含むブログを見る

自動で化粧顔のカメラフィルターとリモートワーク。資生堂のセンスが最高に秀逸

これすごい!

— 塩谷 舞(しおたん) (@ciotan) 2016年10月7日

家にいながら、すっぴんでSkypeミーティングしても、自動的にお化粧された顔が相手に映る新サービス!資生堂さんとMicrosoftさんの共同開発。

マジで働く女子のニーズに応えたサービスで、感動!はやく使いたい!https://t.co/xsDThSyf5r

これほんと素晴らしいと思う。カメラフィルターアプリ流行の時代かつリモートワーク推進の時勢に乗せて、しかもそれを"資生堂"がプロデュースしてるのイケイケ過ぎる。課題発見・着眼点と時代に合わせた解決法が秀逸。

大手美容系ブランドのインターネット的な施策だと、やれ「F2F3向けのデジタルマーケティングがhogehoge」 、「@cosmeのランキング上げるためにfugafuga」、「自社ECサイトへの流入経路とコンバージョンがfoobar」という話に終始しているように思えるけど、資生堂はリアルな化粧を売るのと同時に、"デジタルな化粧"も売っていこうという意識があるのかもしれない。社内の偉いおっさんでは到底思いつけない、ユーザー目線にたった今の時代を生きる女性社員の方々が目に浮かぶ。感動した。

上記のデモ動画(?)では"フィルター化粧"も全く自然に見える。最近のカメラフィルターアプリの進化はすごいし技術的にはそこまでハードルなかったのかな